Auf Basis von wissenschaftlichen Daten habe ich mit Hilfe von Algorithmen in der Software „PureData“ Klänge und Bilder erzeugt.

Am 14. Oktober 2022 habe ich mein Praktikum bei Studio Fluffy gestartet. Da ich weder Kenntnisse noch Erfahrung mit Programmierungs-Anwendungen für Sound wie „PureData“ hatte, arbeitete ich mich als Anfänger in die Software „PureData“ ein um generatives Sound Design zu entwickeln.

Hauptsächlich habe ich mir autodidaktisch Fertigkeiten in „PureData“ angeeignet. Insbesondere haben mir die Youtube Videos von Andrew Brown das ermöglicht. Es ging zum Beispiel um die Nachahmung von Patchern und die willkürliche, freiwillige Transposition.

Einstieg in PureData

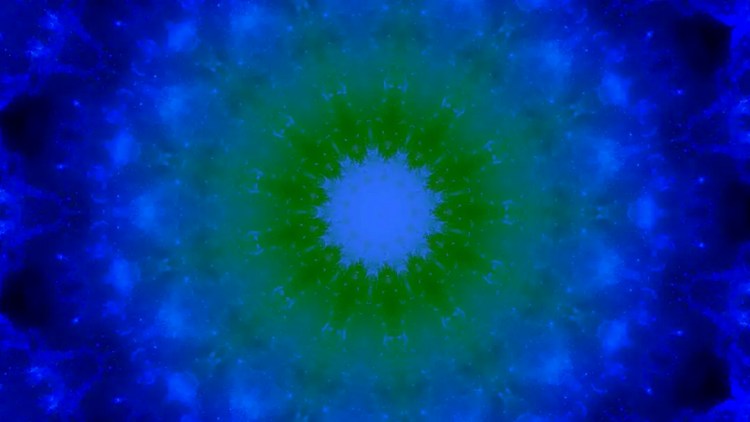

Meine erste Aufgabe war die Bearbeitung einer Image Datei. Mit einer internen Bibliothek (Library) von „PureData“ namens GEM kann man eine Image Datei bearbeiten. Wenn man GEM in „PureData“ einstellt, stehen automatisch Optionen zur Verfügung, die sich um fast alle Bereiche der Gestaltung handeln: Farbe, Größe, Richtung, Licht, Form, usw. Das Objekt, das im Video oben angezeigt wird, ist ein „Kaleidoskope“ Objekt mit 8 Faktoren.

Die zweite Aufgabe war eine Klangskizze. An die durch UNIX Dateien generierte Animation ist die mit „PureData“ Patchers synchronisierbare Musik angebunden. Da die Dateivertonung meine nächste Aufgabe war, habe ich mich konzentriert, die musikalische Idee zu entwickeln und sie mit passender Atmosphäre der Animation übereinstimmen zu lassen.

Bei der Klangskizze habe ich „stochastic synthesis“ verwendet, wo die Klangfarbe nach der Zeit willkürlich geändert wird. Insbesondere werden die Amplitude und Frequenz in die vielen Punkte verzerrt und dadurch wird die Musik generiert, in der sich die Klangfarbe in jeder Schicht unterschiedlich entfaltet. Ich habe die mehreren „stochastic syntheses“ mit „throw/catch“ Objekt (für Multi-Kanalfunktion) nebeneinander gestellt. Dadurch formte ich die Atmosphäre des tiefen und schweren Hintergrundes, die mit der schwarzen Szene abgestimmt ist. Der Patcher ist auch mit viel verzerrten Noteneingaben verbunden, aus denen sich der von innen verschwollene und schäumte Klang ergeben, der mit den mit der Zeit entstehenden und verschwundenen Stilen gut zusammen passt.

Generative Klangerzeugung

Die letzte Aufgabe war die Generative Klangerzeugung. In der vorherigen Aufgabe konnte ich hierfür schon Erfahrung sammeln, indem ich synchronisierbare Musik komponiert habe. In diesem Schritt habe ich mit den von Studio Fluffy zur Verfügung gestellten CSV Dateien einen Patcher formuliert. Der Algorithmus der Dateien wird in Form von Modulen gestartet und lässt die Dateien in Klanggeneratoren einfließen. Das ist eine gesamte Mischung der vorherigen Aufgaben.

Das Prinzip basiert auf Frequency Modulation, aber es gibt eine kleine Abweichung: die Klanggeneratoren addieren nicht, sondern multiplizieren(s. auf den beiden Objekten „osc~“). Der in die Objekte „osc~“ eingeflossene Wert gliedert sich mit zwei Faktoren: MIDI Keyboard Noten und die durch Filterobjekte modulierten Klangobjekte.

Anschließend sind die Klanggeneratoren „osc~“ mit den Dämpfer-Objekten (attenuation) verbunden, die mit anderen Filtern und Delay Buffers außerordentliche klangliche Effekte ergeben.

Der wichtigste Punkt der Klangerzeugung liegt auf diesen Modulen, durch das die CSV Dateien in PureData hineingesetzt werden. Mit meinem selbst gebauten Modulo-Objekt aktualisiert sich das Objekt, das zum Text-Lesen dient. Danach fließen die Dateien, die schon von CSV zu Textfile konvertiert und in 3 Zeilen eingeordnet wurden, durch das „unpack“ Objekt in die Klanggeneratoren hinein: die Vertonung der Dateien.

Meine Ergebnisse

Die vertonten Dateien sollten als kleine aber konstant verzerrte Klänge empfangen werden und mit der Noteneingabe werden sie sowohl durch Filterobjekte als auch Delay-Buffer-Objekten den Sound erzeugen, wie zum Beispiel die sprudelnden Wasserblasen aus der Tiefe in einem See blubbern.

Natürlich können die Dateien der eingesetzten Module mit dem Patcher für Image-Bearbeitung verbunden werden, während die Klänge erzeugt werden. Dadurch wird die Image-Bearbeitung in verzerrter Weise ablaufen: Bildsimulation mit Sound.

Selbstverständlich will ich an dieser Stelle sagen, dass ich ohne die Hilfe und Unterstützung von Studio Fluffy mein Praktikum nicht erfolgreich abgeschlossen hätte. Dafür bedanke ich mich bei Studio Fluffy, bei Sierk und Johannes.

Doyeong Kim studiert Musikinformatik an der Hochschule für Musik in Karlsruhe und war Praktikant bei Studio Fluffy.